- Đăng ngày

Open WebUI: Nền Tảng AI Tự Host Mạnh Mẽ Cho Doanh Nghiệp Và Nhà Phát Triển

- Tác giả

- Tên

- caphe.dev

- @caphe_dev

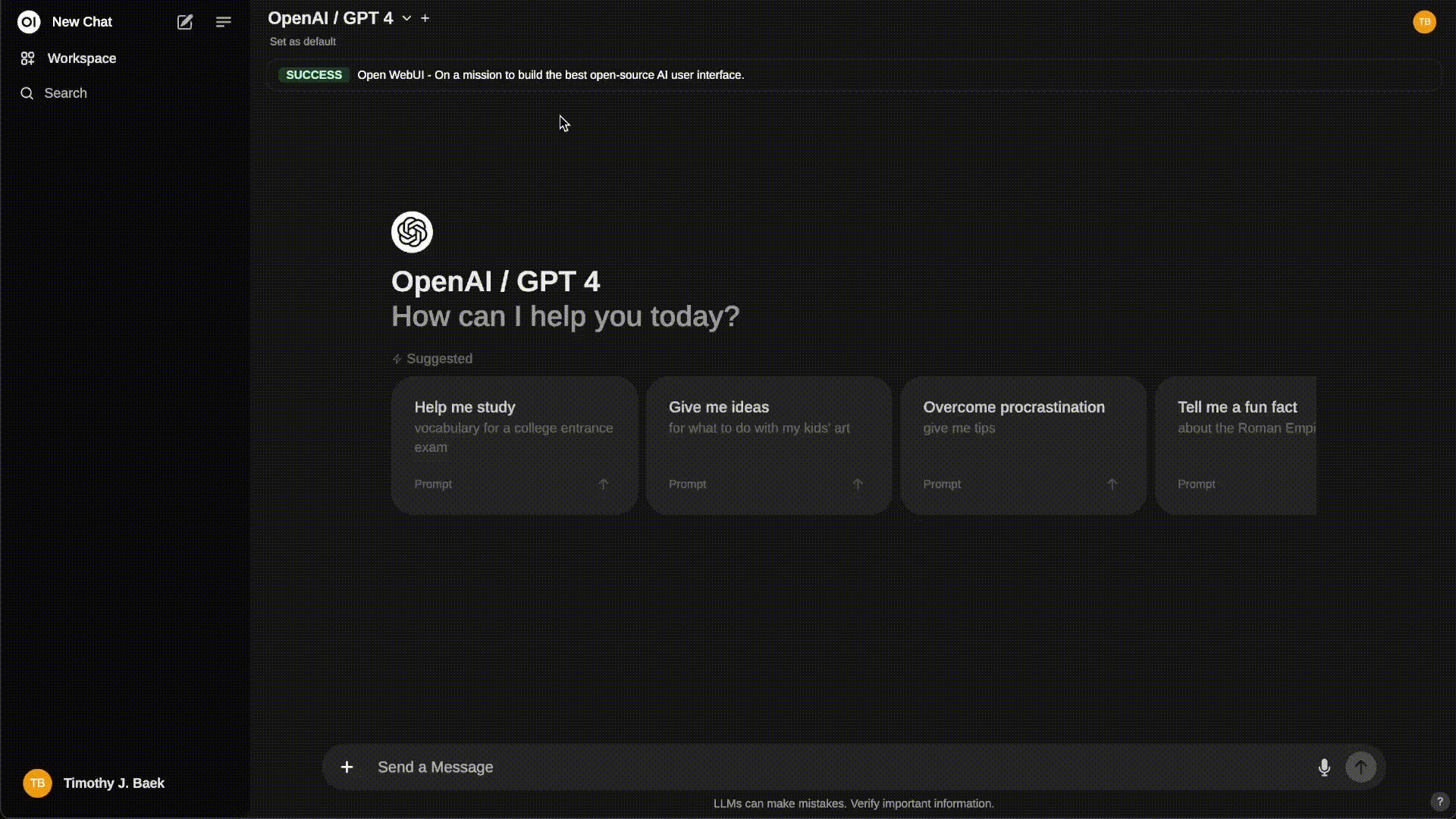

Open WebUI đã nhanh chóng trở thành một trong những giải pháp hàng đầu cho việc triển khai AI cục bộ, cung cấp giao diện web tự host mạnh mẽ với hơn 77,700 sao trên GitHub[1][2]. Dự án mã nguồn mở này không chỉ hỗ trợ các mô hình ngôn ngữ lớn (LLM) thông qua Ollama mà còn tích hợp liền mạch với các API OpenAI, mang đến sự linh hoạt chưa từng có cho cả doanh nghiệp và nhà phát triển[3][5]. Với khả năng hoạt động hoàn toàn offline và kiến trúc mở rộng, Open WebUI đang định hình lại cách chúng ta tương tác với AI trong môi trường cục bộ.

Kiến Trúc Và Cách Thức Hoạt Động

Mô Hình Client-Server Hiện Đại

Open WebUI xây dựng trên kiến trúc client-server tối ưu, kết hợp frontend Svelte hiệu suất cao với backend FastAPI mạnh mẽ[7]. Hệ thống sử dụng WebSocket để xử lý luồng dữ liệu thời gian thực, cho phép trải nghiệm chat mượt mà tương tự ChatGPT. Cơ chế RAG (Retrieval-Augmented Generation) được tích hợp sâu thông qua Chroma DB, giúp tăng cường khả năng trả lời bằng cách tham chiếu dữ liệu nội bộ[9].

Ví dụ về luồng xử lý một truy vấn:

- Người dùng nhập câu hỏi qua giao diện web

- Frontend gửi yêu cầu đến backend qua API REST/WebSocket

- Hệ thống RAG truy vấn Chroma DB để tìm ngữ cảnh liên quan

- LLM (Ollama hoặc API OpenAI) xử lý thông tin và tạo phản hồi

- Kết quả được stream về client qua WebSocket

Hỗ Trợ Đa Nền Tảng

Khả năng tương thích của Open WebUI thể hiện qua việc hỗ trợ cả CPU và GPU thông qua Docker[8]. Đối với hệ thống NVIDIA, chỉ cần thêm flag --gpus all để kích hoạt acceleration. Kiến trúc container hóa cho phép triển khai trên mọi nền tảng từ Raspberry Pi đến server doanh nghiệp, với mức tiêu thụ tài nguyên tối ưu.

Triển Khai Và Quản Lý

Cài Đặt Từng Bước Với Docker

Quá trình triển khai được đơn giản hóa tối đa qua Docker. Đối với hệ thống có GPU:

docker run -d -p 3000:8080 --gpus all \\

-v ollama:/root/.ollama \\

-v open-webui:/app/backend/data \\

--name open-webui \\

--restart always \\

ghcr.io/open-webui/open-webui:cuda

Phiên bản CPU-only thậm chí còn nhẹ hơn, yêu cầu tối thiểu 2GB RAM[4]. Hệ thống volume được thiết kế để bảo toàn dữ liệu qua các lần update, đảm bảo tính liên tục trong vận hành.

Quản Lý Phiên Bản Và Cập Nhật

Open WebUI tích hợp Watchtower để tự động cập nhật:

docker run -d --name watchtower \\

--restart unless-stopped \\

-v /var/run/docker.sock:/var/run/docker.sock \\

containrrr/watchtower --interval 300 open-webui

Cơ chế rolling update đảm bảo thời gian downtime gần như bằng không, cực kỳ phù hợp cho các hệ thống production[8].

Tính Năng Đột Phá Cho Doanh Nghiệp

Tích Hợp Đa Nguồn LLM

Không giới hạn ở Ollama, Open WebUI hỗ trợ mọi API tương thích OpenAI như Groq, Claude hay Mistral[3][5]. Cấu hình thêm model mới chỉ qua vài click:

- Truy cập Settings > Model

- Thêm endpoint API

- Đặt tên và cấu hình tham số

- Lưu và kiểm tra kết nối

Hệ Thống Quản Lý Người Dùng Chi Tiết

Tính năng RBAC (Role-Based Access Control) cho phép phân quyền đến từng chức năng[5][9]. Doanh nghiệp có thể tạo các nhóm người dùng với quyền hạn cụ thể:

- Admin: Toàn quyền cấu hình hệ thống

- Developer: Tạo/tinh chỉnh model

- User: Chỉ sử dụng model đã được phê duyệt

- Auditor: Xem nhật ký hoạt động

RAG Nâng Cao Với Tùy Biến Doanh Nghiệp

Cơ chế RAG trong Open WebUI cho phép nhúng tài liệu nội bộ vào quá trình xử lý[10]. Ví dụ upload báo cáo tài chính PDF để AI phân tích:

- Tạo collection mới trong RAG

- Upload các file PDF/Word

- Thiết lập metadata và tags

- Liên kết collection với model

Kết quả: Khi hỏi về số liệu kinh doanh, AI tự động tham chiếu tài liệu đã upload để đưa ra câu trả lời chính xác.

Bảo Mật Và Tuân Thủ

Mã Hóa End-to-End

Tất cả dữ liệu được mã hóa AES-256 khi lưu trữ[7]. Open WebUI hỗ trợ tích hợp Vault để quản lý key, phù hợp với các yêu cầu compliance khắt khe như GDPR hay HIPAA.

Kiểm Soát Truy Cập Vật Lý

Với khả năng chạy hoàn toàn offline, doanh nghiệp có thể triển khai Open WebUI trên mạng nội bộ không kết nối Internet[4][5]. Tính năng air-gapped deployment đảm bảo dữ liệu nhạy cảm không bao giờ rời khỏi phòng server.

Phát Triển Và Mở Rộng

Hệ Sinh Thái Plugin

Kiến trúc module hóa cho phép thêm tính năng mới qua plugin[7]. Ví dụ tạo plugin xử lý ảnh:

- Khởi tạo thư mục plugin

- Định nghĩa API endpoint mới

- Triển khai logic xử lý ảnh

- Đóng gói và cài đặt qua admin panel

Tích Hợp CI/CD

Open WebUI hỗ trợ full API để tích hợp vào pipeline DevOps[8]. Script mẫu triển khai model mới qua GitLab CI:

deploy_model:

stage: deploy

script:

- curl -X POST "${OPENWEBUI_URL}/api/models"

-H "Authorization: Bearer ${API_KEY}"

-F "model=@${MODEL_FILE}"

-F "config=@${CONFIG_FILE}"

Xu Hướng Và Tương Lai

Edge AI Và IoT

Khả năng chạy trên thiết bị biên như Raspberry Pi mở ra ứng dụng trong lĩnh vực IoT[10]. Ví dụ triển khai hệ thống giám sát an ninh thông minh:

- Camera tích hợp Open WebUI

- Xử lý hình ảnh cục bộ qua LLM

- Cảnh báo real-time mà không cần cloud

Hỗ Trợ Đa Phương Thức

Bản roadmap 2025 của Open WebUI hứa hẹn thêm hỗ trợ xử lý video real-time và AR[7]. Điều này sẽ cách mạng hóa lĩnh vực telemedicine và remote assistance.

Kết Luận

Open WebUI không chỉ là giao diện web mà là cả một hệ sinh thái AI tự host hoàn chỉnh. Với hơn 230 contributor và cộng đồng 156,000 người dùng[6][8], dự án đang định hình tương lai của AI phi tập trung. Doanh nghiệp có thể bắt đầu với phiên bản community miễn phí, sau đó nâng cấp lên enterprise để được hỗ trợ SLA và các tính năng cao cấp như custom branding[5][8].

Xu hướng AI tự host đang lên ngôi trong bối cảnh lo ngại về privacy và chi phí cloud. Open WebUI chính là chìa khóa để doanh nghiệp làm chủ công nghệ AI, tối ưu hóa quy trình mà vẫn đảm bảo an toàn dữ liệu.

Sources