- Đăng ngày

Ollama, LM Studio Và Ứng Dụng LLM Gen AI chạy ở máy tính cá nhân

- Tác giả

- Tên

- caphe.dev

- @caphe_dev

Trong thế giới phát triển nhanh chóng của trí tuệ nhân tạo, việc chạy các mô hình ngôn ngữ lớn (LLM) trên máy tính cá nhân đã trở thành xu hướng mới nhờ những công cụ như Ollama và LM Studio. Những giải pháp này không chỉ mang lại sự linh hoạt trong sử dụng mà còn đảm bảo tính bảo mật dữ liệu tuyệt đối[3][6]. Bài viết này sẽ đưa bạn đi từ khái niệm cơ bản đến hướng dẫn thực hành chi tiết, đồng thời khám phá các ứng dụng thực tế của LLM local trong đời sống.

Bản Chất Của LLM Local Và Tại Sao Bạn Nên Quan Tâm

Định Nghĩa LLM Local

Mô hình ngôn ngữ lớn local (Local LLM) là phiên bản AI chạy trực tiếp trên phần cứng cá nhân mà không cần kết nối internet[3][6]. Khác với ChatGPT hay Claude yêu cầu kết nối đám mây, các LLM này hoạt động độc lập như Microsoft Word so với Google Docs - mang lại sự chủ động hoàn toàn cho người dùng.

Lợi thế cốt lõi nằm ở việc kiểm soát dữ liệu đầu vào/ra: Mọi thông tin nhạy cảm như hồ sơ y tế, dữ liệu tài chính hay hợp đồng kinh doanh đều được xử lý nội bộ[3][6]. Điều này đặc biệt quan trọng với doanh nghiệp cần tuân thủ GDPR hay HIPAA.

So Sánh LLM Local Và Dịch Vụ Đám Mây

Bảng phân tích dưới đây làm rõ sự khác biệt:

| Tiêu Chí | LLM Local | Dịch Vụ Đám Mây |

|---|---|---|

| Bảo Mật | Dữ liệu lưu trữ local | Rủi ro rò rỉ dữ liệu |

| Chi Phí | Một lần đầu tư phần cứng | Phí thuê bao hàng tháng |

| Tốc Độ | Phụ thuộc cấu hình | Ổn định nhưng có độ trễ |

| Tùy Biến | Cao, chỉnh sửa được model | Hạn chế theo nhà cung cấp |

| Yêu Cầu Internet | Không bắt buộc | Bắt buộc |

Nghiên cứu từ HocCodeAI chỉ ra 73% doanh nghiệp vừa và nhỏ chuyển sang LLM local để giảm 40% chi phí vận hành hàng năm[3]. Đặc biệt với các tác vụ xử lý ngôn ngữ địa phương như tiếng Việt, LLM local cho phép tùy chỉnh từ vựng và ngữ cảnh phù hợp hơn[8].

Hệ Sinh Thái Công Cụ LLM Local Phổ Biến

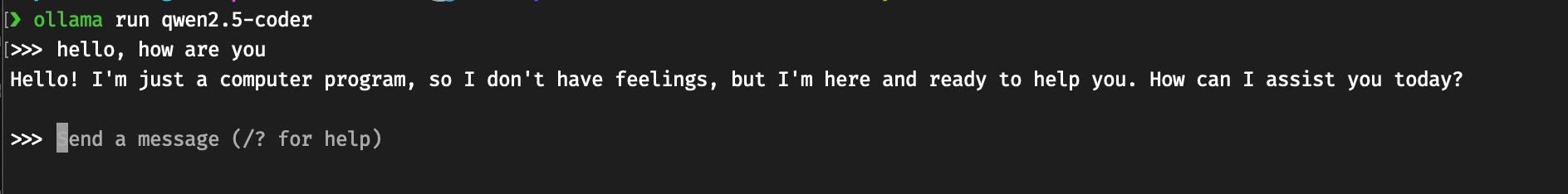

Ollama - "Docker" Cho Thế Giới AI

Ollama nổi bật như một nền tảng mã nguồn mở, cho phép quản lý và triển khai LLM qua giao diện dòng lệnh đơn giản[1][11]. Hệ thống tự động tối ưu hóa cho phần cứng có sẵn, từ GPU cao cấp đến CPU thông thường.

Quy trình làm việc điển hình:

- Tải model qua lệnh

ollama pull llama3.1 - Khởi chạy với

ollama run llama3.1 - Tương tác trực tiếp qua terminal hoặc tích hợp với GUI như Open WebUI[4]

Ưu điểm chính của Ollama nằm ở khả năng tạo model tùy biến qua Modelfile, tương tự Dockerfile[11]. Ví dụ tạo chatbot du lịch:

FROM llama3.1

PARAMETER temperature 1

SYSTEM "Bạn là trợ lý ảo du lịch của Vietnam Airlines"

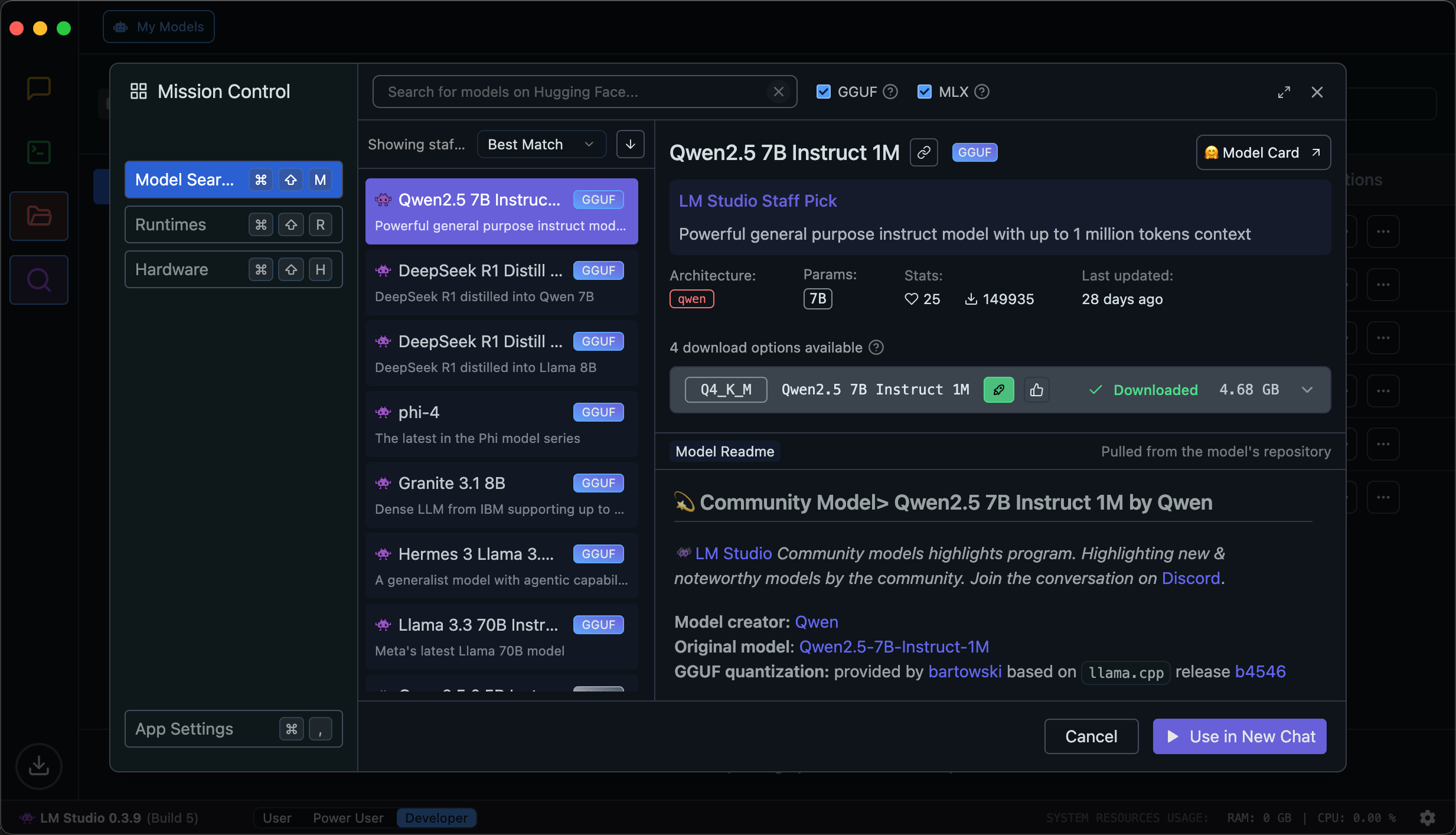

LM Studio - Cửa Hàng AI Trên Máy Tính

Nếu Ollama thiên về developer, LM Studio mang đến trải nghiệm "all-in-one" với giao diện trực quan[2][8]. Công cụ này tích hợp kho model từ Hugging Face, hỗ trợ cả model tiếng Việt như PhoGPT.

Quy trình sử dụng cơ bản:

- Tải model qua giao diện tìm kiếm

- Chọn preset cấu hình phù hợp với phần cứng

- Tương tác qua cửa sổ chat hoặc API local[10]

Điểm mạnh của LM Studio là khả năng chạy server local, biến máy tính thành trung tâm AI cá nhân. Người dùng có thể tích hợp vào ứng dụng qua endpoints như /v1/chat/completions tương thích với OpenAI API[10][14].

Cấu Hình Phần Cứng Tối Ưu Cho LLM Local

Yêu Cầu Tối Thiểu

Theo khuyến nghị từ HocCodeAI[3]:

- GPU: NVIDIA RTX 3060 (8GB VRAM) trở lên

- RAM: 16GB cho model 7B parameters

- Ổ Cứng: SSD 256GB trở lên

Với model lớn như Llama3.2 70B:

- VRAM yêu cầu: 24GB+

- RAM đề xuất: 64GB

- Băng thông bộ nhớ tối thiểu: 400GB/s

Tối Ưu Hóa Phần Cứng

Thực nghiệm từ TechMaster chỉ ra cách tăng hiệu suất:

- Kích hoạt NVIDIA CUDA trong cài đặt driver

- Sử dụng định dạng model 4-bit quantization

- Áp dụng kỹ thuật offloading để phân bổ tải cho CPU/GPU[2]

- Cấu hình swap memory trên Linux khi thiếu VRAM

Ví dụ câu lệnh khởi chạy với LM Studio:

model = AutoModelForCausalLM.from_pretrained(

"mistral-7b",

load_in_4bit=True,

device_map="auto"

)

Ứng Dụng Thực Tế Cho Người Dùng Phổ Thông

Trợ Lý Ảo Đa Năng

LLM local có thể trở thành:

- Trợ lý viết lách: Soạn thảo email, bài viết blog

- Cố vấn tài chính: Phân tích chi tiêu, gợi ý đầu tư

- Gia sư AI: Giải thích khái niệm khoa học[12]

Ví dụ với Ollama:

ollama run gemma:7b "Hãy viết thư cảm ơn khách hàng bằng tiếng Việt trang trọng"

Xử Lý Tài Liệu Nội Bộ

Tính năng RAG (Retrieval-Augmented Generation) cho phép:

- Tổng hợp báo cáo từ file PDF/Word

- Phân tích hợp đồng pháp lý

- Tạo FAQ tự động từ tài liệu đào tạo

Triển khai với LlamaIndex:

from llama_index import VectorStoreIndex

index = VectorStoreIndex.from_documents(documents)

query_engine = index.as_query_engine()

response = query_engine.query("Tóm tắt các điều khoản bảo mật")

Phát Triển Ứng dụng AIoT

Kết hợp LLM local với thiết bị IoT:

- Hệ thống nhà thông minh điều khiển bằng giọng nói

- Robot dịch vụ sử dụng vision model

- Hệ thống giám sát an ninh thông minh

Ví dụ tích hợp LM Studio với Raspberry Pi:

import requests

response = requests.post(

"<http://localhost:1234/v1/chat/completions>",

json={"model": "llama3.1", "messages": [...]}

)

Xu Hướng Và Dự Báo Phát Triển

Theo báo cáo từ Intel[5], thị trường LLM local dự kiến tăng trưởng 45% CAGR giai đoạn 2025-2030. Các xu hướng nổi bật bao gồm:

- Model đa phương thức (multimodal) xử lý hình ảnh/âm thanh[13]

- Kỹ thuật LoRA cho phép fine-tuning hiệu quả[6]

- Tích hợp neural engine trên CPU thế hệ mới

- Hỗ trợ lượng token context lên đến 1M

Dự án mã nguồn mở như GPT4All đang cách mạng hóa việc chạy LLM trên Raspberry Pi với hiệu năng được tối ưu[9]. Điều này mở ra tiềm năng ứng dụng AI ở mọi thiết bị từ smartphone đến hệ thống nhúng.

Kết Luận Và Khuyến Nghị

Hành trình khám phá LLM local qua Ollama và LM Studio đã cho thấy tiềm năng to lớn của công nghệ này. Đối với người dùng phổ thông, việc bắt đầu có thể đơn giản như:

- Thử nghiệm model 7B parameters trên laptop cá nhân

- Tích hợp vào workflow xử lý văn bản hàng ngày

- Xây dựng chatbot chuyên ngành nhỏ

Các tổ chức nên xem xét đầu tư vào:

- Hạ tầng phần cứng chuyên dụng

- Đào tạo nhân sự vận hành LLM

- Phát triển bộ model tùy chỉnh theo nghiệp vụ

Tương lai của LLM local hứa hẹn xóa nhòa ranh giới giữa AI đám mây và thiết bị cá nhân, mang đến thế hệ ứng dụng thông minh mới - nơi quyền riêng tư và sức mạnh xử lý song hành.

Sources